Инструменты сбора данных с использованием искусственного интеллекта, такие как GPTBot, набирают популярность, одновременно порождая вызовы в области обеспечения кибербезопасности и необходимость в разработке эффективных методов противодействия активности ботов. В данной статье рассмотрим рост скрытого парсинга данных с помощью AI. Для решения этой проблемы владельцы веб-сайтов могут использовать Rate Limiting, применять файл robots.txt и выборочные блокировки IP-адресов с использованием доверенных черных списков.

За последние годы искусственный интеллект стал более доступным, что не только открыло новые возможности для внедрения инноваций и повышения эффективности во многих сферах, но и подчеркнуло необходимость поиска надежных методов защиты веб-сайтов от ботов. Широкое распространение и доступность технологий AI также привело к проблемам с защитой веб-сайтов от парсинга и неправомерного использования данных AI-ботами. В данной статье мы рассмотрим основные рекомендации по защите веб-сайтов от несанкционированного AI-парсинга.

Расцвет AI-парсинга

Одним из значительных достижений в области искусственного интеллекта, привлекшим внимание СМИ, является GPTBot – краулер, разработанный компанией OpenAI. GPTBot играет важную роль в сборе данных в реальном времени, которые затем используются для обучения языковой модели ChatGPT от OpenAI. Это позволяет ChatGPT генерировать релевантный текст и изображения в ответ на запросы пользователей. Однако следует отметить, что необходимо проявлять осторожность, управляя GPTBot’ом, чтобы избежать возможных негативных последствий.

Согласно нашим данным, в третьем квартале 2023 года в некоторых случаях доля трафика, приходящегося на GPTBot, достигала до 90% на сайтах интернет-магазинов. Несмотря на то, что GPTBot является легитимным инструментом, разработанным авторитетной организацией, его неуправляемая активность может значительно нагружать серверы и потреблять значительные ресурсы. Это в свою очередь может негативно сказываться на производительности сайта, что подчеркивает важность защиты от ботов и использования специального программного обеспечения для борьбы с ними.

Сбор данных искусственного интеллекта: за пределами GPTBot

GPTBot – лишь верхушка айсберга, когда дело касается сбора данных AI. Множество коммерческих сервисов, стартапов и AI -ассистентов используют различные языковые модели, некоторые из которых даже могут оказаться пиратскими. Объединяет их всех одно: для обеспечения быстрой работы и актуальности предоставляемой информации им требуется огромное количество данных.

Возникает закономерный вопрос: откуда эти организации берут необходимые данные? Крупные и известные компании, такие как OpenAI, имеют партнерские соглашения, обеспечивающие им доступ к информации. Однако небольшие стартапы зачастую вынуждены прибегать к веб-парсингу как основному методу сбора данных.

Множество AI -парсеров работают незаметно, и их активность зачастую ускользает от внимания общественности и веб-сайтов. Эти парсеры намеренно не раскрывают своего присутствия, стремясь избежать обнаружения и потенциального запрета на доступ к веб-ресурсам.

Возможные превентивные меры

В идеале, множество существующих проблем могло бы быть эффективно решено с помощью разработки комплексной нормативно-правовой базы, которая бы регулировала процесс сбора, хранения, обработки и использования данных в системах искусственного интеллекта. К сожалению, на текущий момент деятельность в сфере искусственного интеллекта испытывает недостаток в регулировании. Это приводит к тому, что в связи с отсутствием четких технических стандартов и требований многие компании имеют значительную свободу действий.

Даже на фоне формирования нормативно-правовой базы остаются сомнения в том, будут ли компании добровольно соблюдать какие-либо предписания, особенно учитывая относительную простоту, с которой можно их обходить.

Тем не менее, мы составили два списка рекомендаций. Первый список включает в себя действия, которые мы настоятельно советуем предпринимать всем владельцам веб-сайтов. Второй же список содержит методы, которых мы рекомендуем избегать из-за потенциальных негативных последствий, которые они могут повлечь за собой.

Рекомендуемые действия

Установите Rate Limiting: важной стратегией в борьбе с ботами, осуществляющими AI -парсинг, является введение ограничения скорости. Это представляет собой фундаментальную меру безопасности, которая ограничивает количество запросов, исходящих от одного источника, устанавливая тем самым базовый уровень защиты. Подобная мера позволяет регулировать интенсивность доступа к данным и уменьшает вероятность их недобросовестного использования. Хотя это не является универсальным решением, ограничение скорости может эффективно предотвратить перегрузку вашего сервера. Имейте в виду, что наиболее агрессивные боты стремятся извлечь данные с максимально высокой скоростью, поэтому не давайте им такой возможности.

Применяйте выборочную блокировку IP: в случаях, когда это необходимо, рассмотрите возможность внедрения выборочных блокировок IP-адресов, связанных с интенсивным парсингом. Для более эффективной идентификации и блокировки IP-адресов с известной историей вредоносной активности рекомендуется использовать актуальные черные списки от авторитетных источников, таких как FireHOL. Такой взвешенный подход позволит вам нейтрализовать угрозы высокого риска, минимизируя при этом вероятность ложных срабатываний.

Чего следует избегать

Не применяйте массовые блокировки IP-адресов: избегайте неселективных блокировок IP-адресов. Массовые блокировки без точечного контроля могут случайно ограничить доступ легитимным пользователям, включая тех, кто по разным причинам использует VPN или прокси-серверы. Подобная чрезмерная блокировка способна значительно снизить удобство для пользователей и нанести ущерб репутации вашего сайта.

Будьте осторожны при использовании сервисов веб-защиты: следите, чтобы они не увеличивали время ожидания для пользователей. Крайне важно найти оптимальное соотношение между уровнем безопасности и удобством использования. Излишняя зависимость от таких сервисов может привести к недовольству пользователей и негативно сказаться на юзабилити вашего сайта.

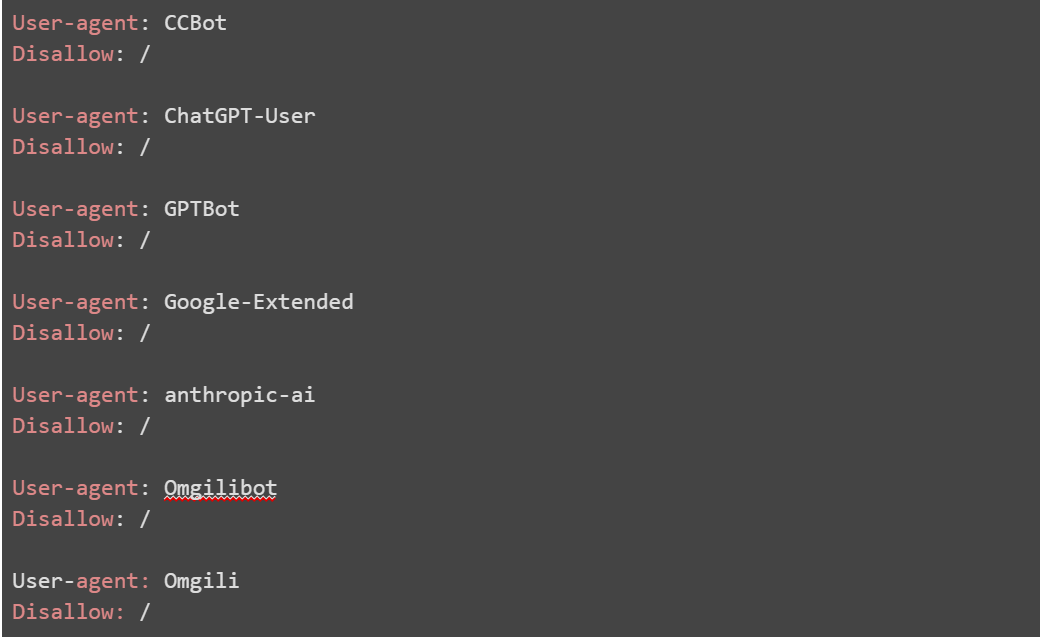

Настройка файла Robots.txt

И наконец, в качестве еще одной из эффективных мер защиты от несанкционированного парсинга является настройка файла robots.txt – добавляем в него ряд ограничений. Этот простой текстовый файл содержит инструкции для добросовестных краулеров о том, какие страницы или разделы вашего сайта не должны быть доступны или проиндексированы.

Несмотря на то, что файл robots.txt не гарантирует полную защиту, он способен ограничить доступ множества краулеров и снизить риск парсинга со стороны более осторожных операторов по извлечению данных.

В качестве еще одного эффективного средства защиты от неавторизованного скрейпинга можно использовать настройку файла robots.txt. Этот файл, представляющий собой простой текст, содержит директивы для поисковых роботов, указывающие, какие страницы или секции сайта не должны индексироваться или посещаться. Несмотря на то, что файл robots.txt не гарантирует полную защиту, он способен ограничить доступ множества краулеров и снизить риск парсинга со стороны более осторожных сканеров.

В списке выше представлены все обнаруженные нами публично идентифицируемые AI-парсеры, доступ которых вы можете ограничить. Однако важно помнить, что этот метод эффективен только для тех парсеров, которые запрограммированы на соблюдение правил, указанных в файле robots.txt. Следовательно, данное решение не является универсальным и не может гарантировать полную защиту от всех возможных парсеров.

Комплексная защита от ботов с помощью Qrator Labs

Защитите свои цифровые активы с помощью Qrator Labs уже сегодня.

Присоединяйтесь к числу наших клиентов, уже оценивших возможности нашего решения Qrator.AntiBot. Qrator.AntiBot успешно заблокировано более 4 миллиардов ежемесячных запросов ботов, что позволило сократить трафик ботов на сайтах на 23% и уменьшить средние потери бизнеса на 9,2%.

Защитите ваш бизнес от захвата учетных записей, парсинга, кражи персональных данных и перегрузки серверов с решением Qrator.AntiBot.