В этом году при написании итогового документа о работе компании за год, мы решили отказаться от пересказа новостей, и хотя полностью избавиться от воспоминаний о произошедшем не удалось, нам хочется поделиться с тобой тем, что все таки получилось сделать — собрать мысли воедино и обратить взор туда, где мы непременно окажемся в самое ближайшее время — в настоящее.

Без лишних предисловий, ключевые выводы за прошлый год:

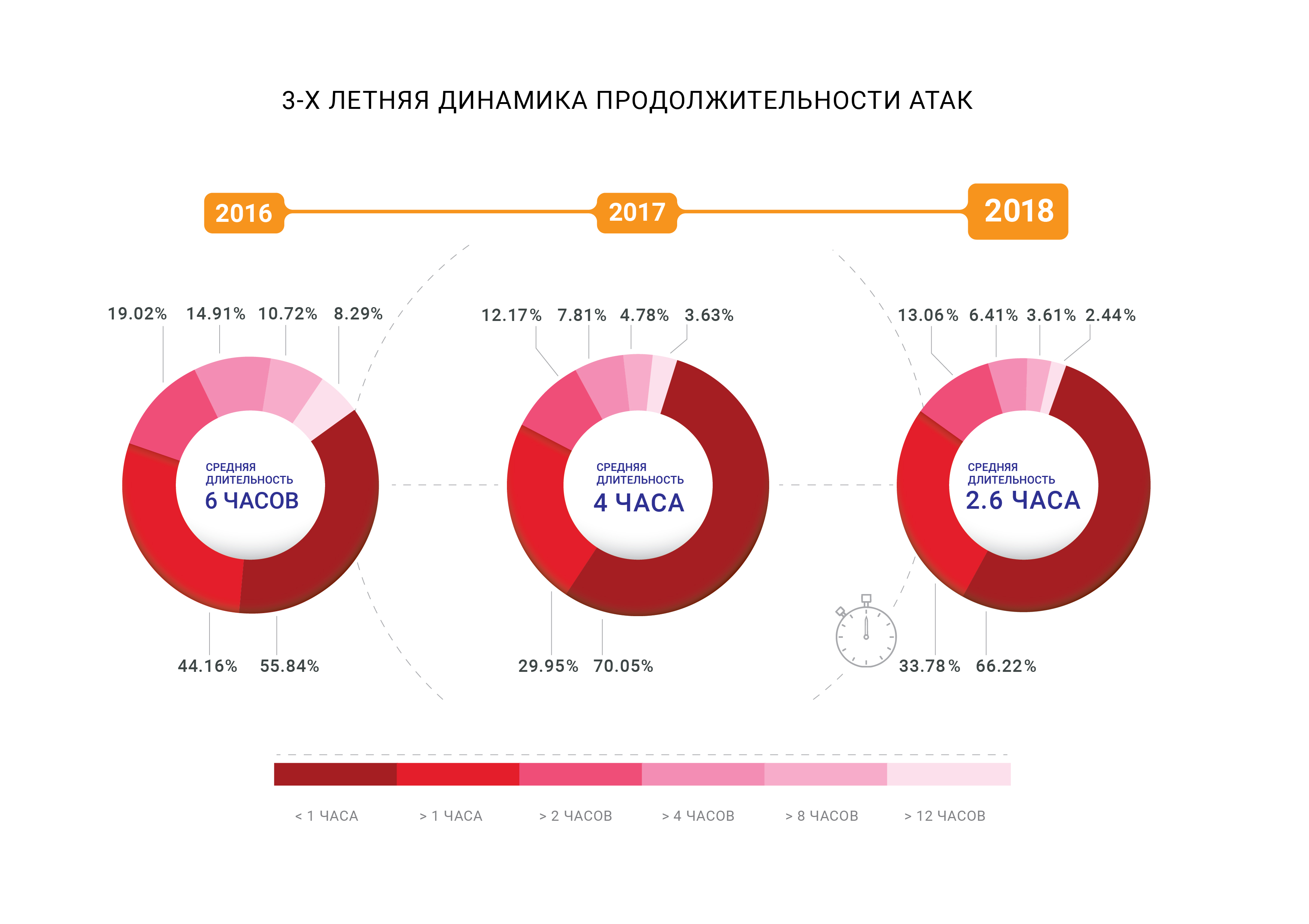

- Средняя длительность DDoS-атак упала до 2,5 часов;

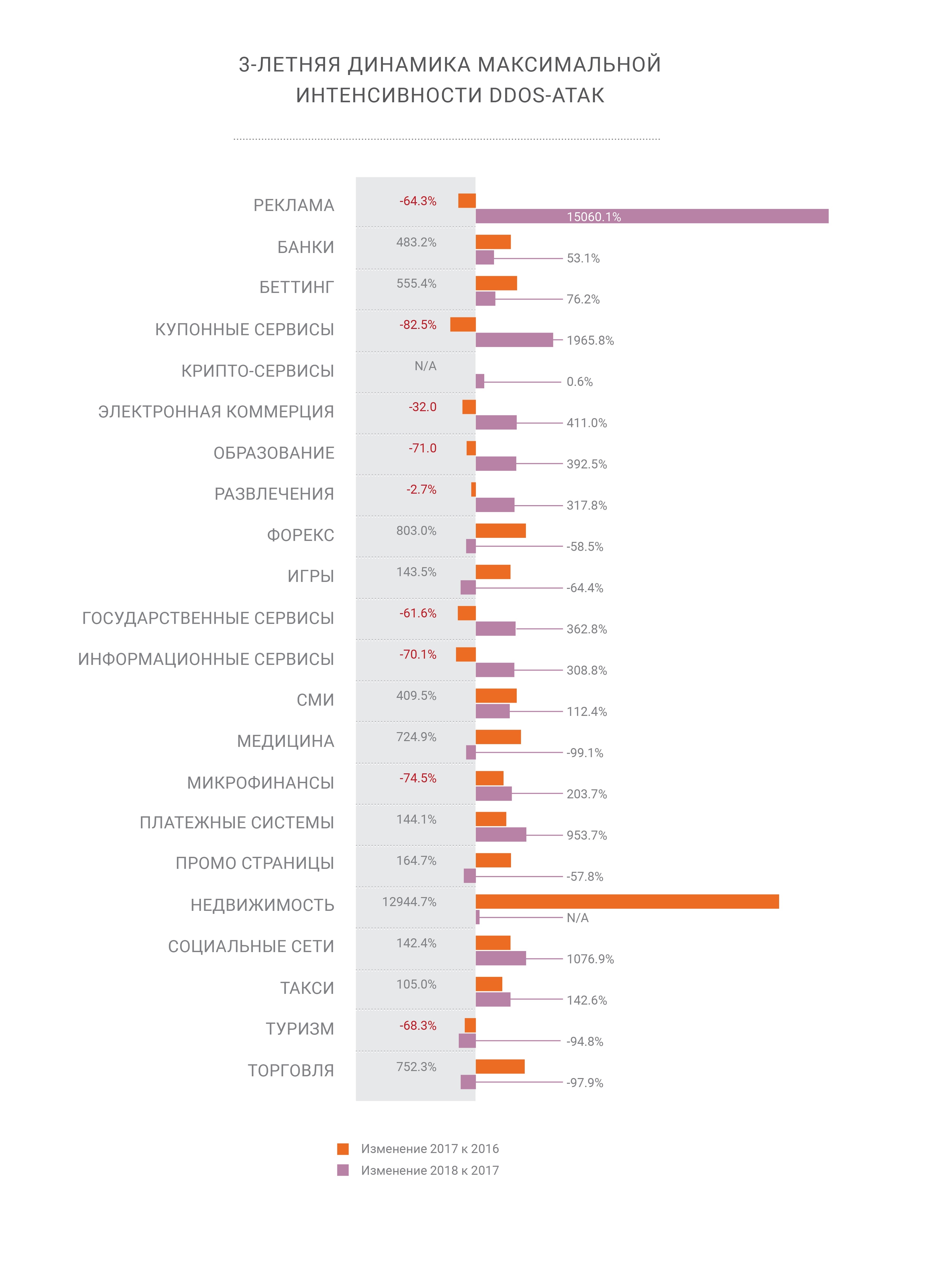

- 2018 год показал наличие вычислительной силы, способной генерировать атаки интенсивностью сотни гигабит в секунду внутри одной страны или региона, подводя нас к краю «квантовой теории относительности пропускной способности»;

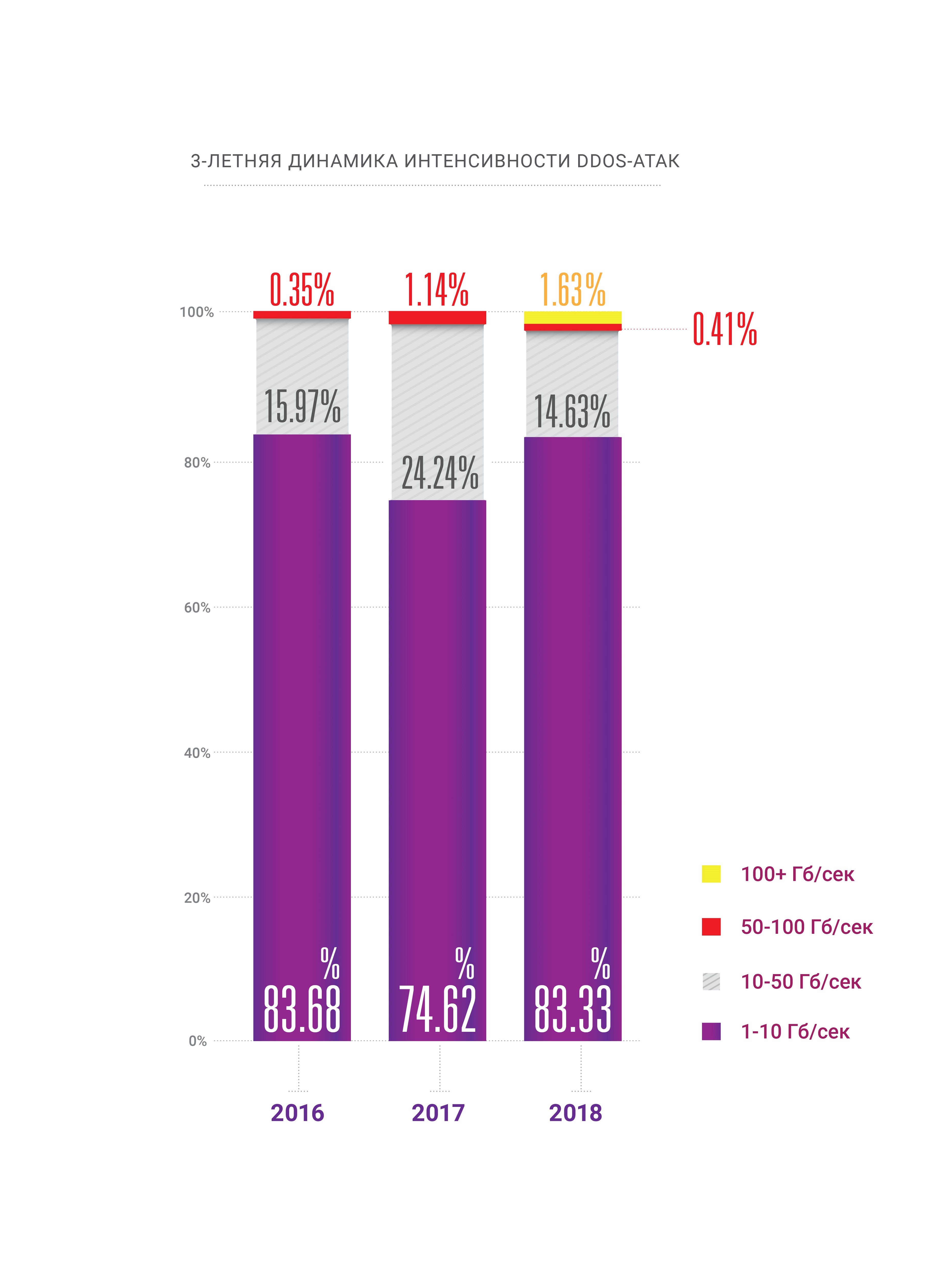

- Интенсивность DDoS-атак продолжает расти;

- Вместе с одновременным ростом доли атак с использованием HTTPS (SSL);

- Персональные компьютеры мертвы — большая часть современного трафика генерируется на мобильных устройствах, представляя собой задачу для организаторов DDoS и следующий вызов для компаний, занимающихся защитой сетей;

- BGP наконец стал вектором атаки, на 2 года позже ожидаемого нами срока;

- Манипуляции DNS по прежнему являются наиболее разрушительным вектором атаки;

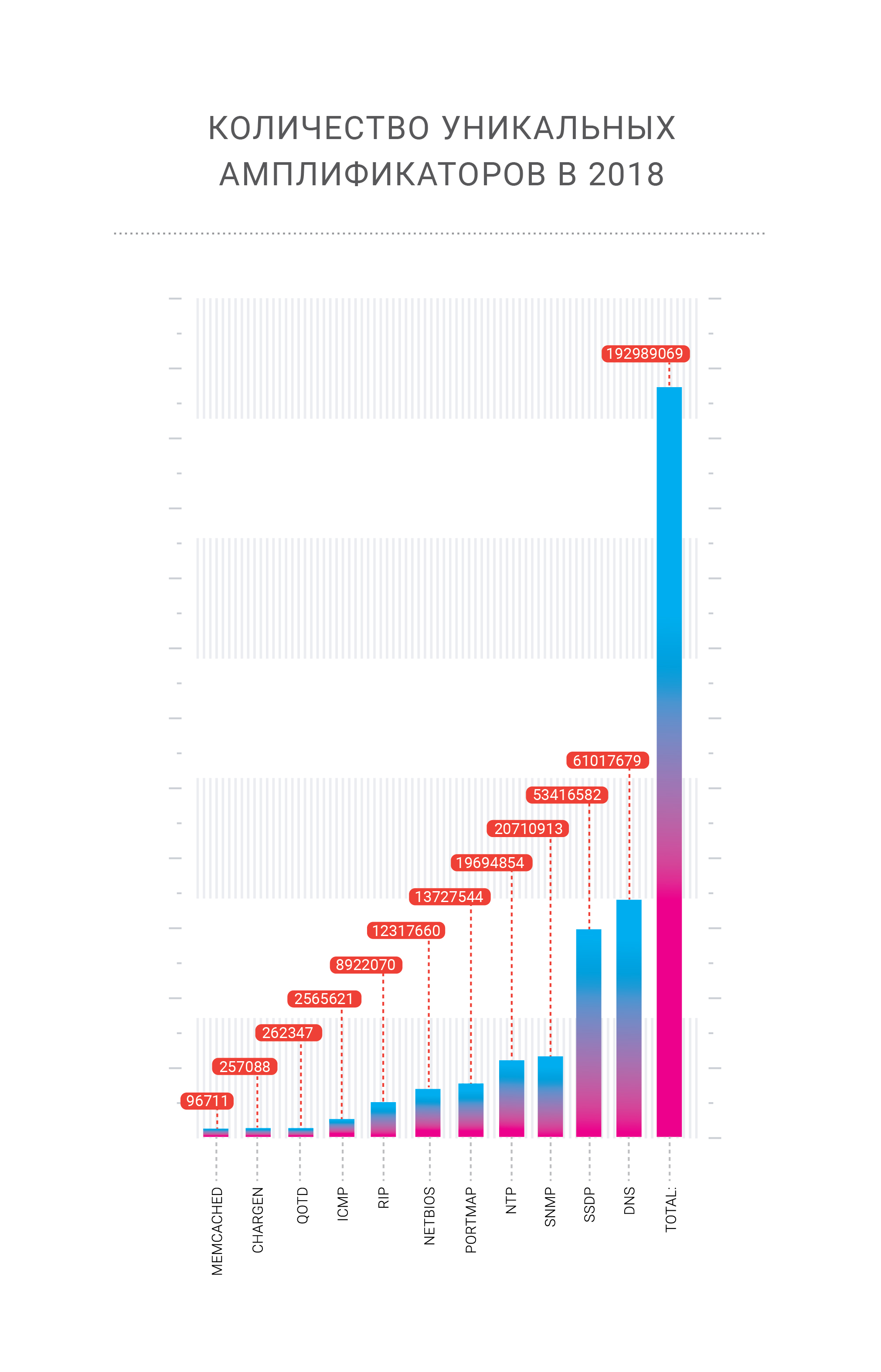

- Мы ожидаем появления новых амплификаторов в будущем, таких как memcached и CoAP;

- «Тихих гаваней» в интернете больше не существует и все отрасли одинаково уязвимы перед кибератаками любого рода.

В публикации мы постарались собрать наиболее интересные части отчета в одном месте, ознакомиться же с полной версией можно по ссылке. Приятного прочтения.

Ретроспектива

В 2018 году наша компания «отметила» две рекордных атаки на собственную сеть. Атаки с амплификацией memcached, которые мы подробно описывали в конце февраля 2018 года, ударили по платежной системе Qiwi с интенсивностью 500 Гбит/сек, но были успешно нейтрализованы сетью фильтрации. В конце октября мы увидели другую знаковую атаку — DNS амплификацию с источниками, локализованными внутри одной-единственной страны, но невиданной ранее мощности.

DNS амплификация была и остается одним из самых известных векторов DDoS-атак канального уровня и до сих пор поднимает два острых вопроса. В случае атаки интенсивностью в сотни гигабит в секунду существует немалая вероятность перегрузки подключения к вышестоящему провайдеру. Как с этим бороться? Очевидно, необходимо распределить такую нагрузку по как можно большему количеству каналов — что приводит нас ко второй проблеме — добавленной сетевой задержке в результате изменения путей движения трафика до мест его обработки. К счастью, мы справились и со второй атакой благодаря гибким опциям балансировки нагрузки внутри сети Qrator.

Именно таким образом балансировка продемонстрировала нам свою высочайшую ценность — так как мы управляем anycast BGP-сетью, наш Radar моделирует распределение трафика по сети после изменения модели балансировки. BGP — это дистанционно-векторный протокол и мы хорошо понимаем состояния, ведь граф дистанций остается почти статичным. Анализируя эти дистанции с учётом LCP и Equal-Cost Multipath мы можем заранее оценить AS_path из точки А в точку Б с высокой степенью точности.

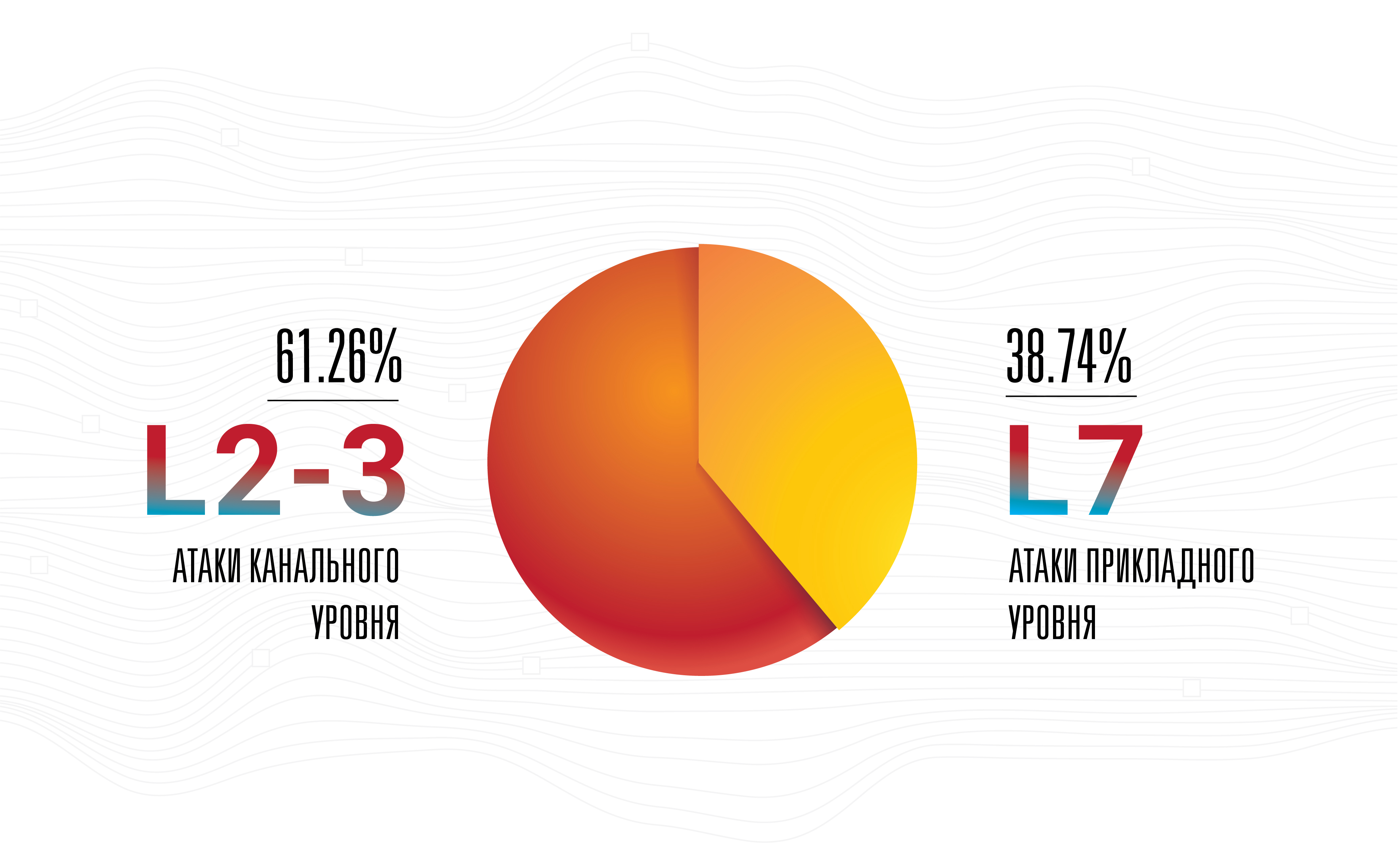

Это не значит, что амплификация является наиболее серьезной угрозой — нет, атаки прикладного уровня остаются наиболее успешными, невидимыми и эффективными, так как большая их часть совершается на низкой интенсивности используемой полосы.

Это основная причина, по которой наша компания бескомпромиссно улучшает соединения с операторами на точках присутствия, одновременно увеличивая их количество. Такой шаг является логичным для любого сетевого оператора в настоящее время, при условии, что бизнес растет. Но мы продолжаем считать, что большинство атакующих сначала собирает ботнет и лишь после начинает выбирать среди широчайшего списка доступных амплификаторов, по которым можно ударить из всех возможных орудий, на максимальной скорости перезарядки. Такие гибридные атаки происходят уже давно, но лишь недавно их интенсивность, как с точки зрения количества пакетов в секунду, так и задействованной сетевой полосы, начала расти.

Ботнеты значительно развились за 2018 год, а их владельцы придумали новое занятие — кликфрод. С улучшением технологий машинного обучения и получением в руки headless-браузеров, работающих без GUI, занятие кликфродом значительно упростилось и удешевилось — всего за два года.

Сегодня среднестатистический веб сайт получает от 50% до 65% трафика от мобильных устройств, их браузеров и приложений. Для некоторых сетевых сервисов, эта доля может доходить до 90% или даже 100%, в то время как исключительно «десктопных» веб сайтов уже практически не существует, разве что внутри корпоративных окружений, либо в виде узкоспециализированных случаев.

Персональные компьютеры, фактически, исчезли с пика сетевого ландшафта к 2019 году, делая некоторые в прошлом успешные техники, такие как слежение за положением мыши, абсолютно нерабочими для целей фильтрации трафика и защиты от ботов. Фактически, не только персональные компьютеры, но и большинство ноутбуков и все-в-одном коробок редко когда являются источником значительной доли посещений страниц, при этом легко становясь оружием. В свое время, простого отказа в доступе чему угодно, некорректно представляющим мобильный браузером еще недавно было вполне достаточно для нейтрализации атак с ботнетов почти полностью, нивелируя отрицательный эффект для ключевых бизнес метрик до нуля.

Создатели и управляющие ботнетами уже привыкли к внедрению практик, имитирующих поведение реальных посетителей страниц в собственный вредоносный код, точно так же, как владельцы веб-страниц привыкли к тому, что браузеры на персональных компьютерах имеют значение. И то и другое видоизменяются, при этом первое — быстрее последнего.

Мы уже заявили, что ничего не изменилось в 2018 году, но прогресс и сами изменения претерпели значительную эволюцию. Один из наиболее ярких примеров — машинное обучение, где улучшения и прогресс были хорошо заметны, особенно в области генеративно-состязательных сетей. Медленно, но верно, ML достигает массового рынка. Машинное обучение уже стало вполне доступным и, как показала граница 2018-2019 годов, уже не является ограниченной до академиков отраслью.

И хотя мы ожидали появления первых основанных на ML-алгоритмах DDoS-атак уже к началу 2019 года — до сих пор подобного не случилось. Тем не менее, это не меняет наших ожиданий, но лишь подогревает их, особенно учитывая снижающуюся стоимость управления нейросетями и постоянно повышающуюся точность их аналитики.

С другой стороны, если рассмотреть текущее состояние индустрии «автоматизированных человеческих особей», то становится ясно, что имплементация нейросети в эту конструкцию является потенциально прорывной идеей. Подобная сеть может учиться на поведении реальных людей в контексте управления веб-страницами. Подобную вещь назовут «пользовательский опыт искусственного интеллекта» и, конечно же, подобная сеть, вооруженная веб браузером, может расширить арсенал обеих сторон: атакующей и защищающейся.

Обучение нейросети дорогостоящий процесс, но распространение и аутсорсинг подобной системы мог бы быть дешев, эффективен и, потенциально, даже бесплатен — в случае, когда вредоносный код прячется внутри взломанных приложений, расширений и много чего другого. Потенциально, подобная перемена могла бы изменить всю индустрию так же, как генеративно-состязательные сети трансформировали наше понимание «визуальной реальности» и «достоверности».

Учитывая продолжающуюся гонку между поисковыми движками — в первую очередь Google и всеми остальными, кто пытается осуществлять их реверс-инжиниринг, дело может дойти до, пока, совсем фантастических вещей — таких как имитация ботом одного-единственного, конкретного, человека. Как правило сидящего за уязвимым компьютером. Версии проекта Captcha и ReCaptcha могут служить примером того, как быстро и сильно атакующая сторона развивает и улучшает собственные инструменты и техники нападения.

После memcached было много разговоров о вероятности (или невероятности) появления совершенно нового класса вооружения для DDoS — уязвимости, бота, некорректно настроенного сервиса или чего-то еще, что будет бесконечно посылать данные по специфической цели, выбранной атакующим. Одна команда от атакующего вызывает непрерывный поток трафика, такого как любой из флудов, или отправка syslog. На текущий момент — это теория. Мы по прежнему не можем сказать, существуют ли подобные серверы, устройства, но если ответ на такой вопрос утвердителен — будет недооценкой ситуации сказать, что подобная вещь может стать невероятно опасным оружием в злых руках.

В 2018 году мы также увидели нарастающий интерес в том, что называется «управлением интернетом» и связанными с ним сервисами со стороны государств и некоммерческих организаций по всему миру. Мы относимся нейтрально к подобному развитию событий до того момента, когда начинается подавление фундаментальных гражданских и индивидуальных свобод, чего мы надеемся не случится в развитых странах.

Наконец, спустя годы сбора и анализа трафика атак по всему миру, Qrator Labs готова к имплементации блокировки по первому сетевому запросу. Модели, которые мы используем для предсказания злонамеренного поведения позволяют нам с высокой точностью определять легитимность пользователя для каждой конкретной страницы. Мы продолжаем настаивать на собственной философии безбарьерного входа для пользователя и неразрывного пользовательского опыта, без JavaScript-проверок или капчи, которая с 2019 года начнет работать еще быстрее, обеспечивая высочайший уровень доступности защищаемых сервисов.

Mellanox

Наша компания выбрала 100G свитчи Mellanox в результате внутреннего тестирования, проводившегося в течение нескольких лет. Мы по прежнему отбираем то оборудование, которое лучше всего выполняет наши достаточно специфические требования в определенных условиях наилучшим образом. Например, свитч не должен сбрасывать маленькие пакеты на line rate — предельной скорости, неприемлема даже минимальная деградация. К тому же, свитчи Mellanox обладают приятной ценой. Однако это не все — справедливость цены подтверждается тем, как тот или иной вендор реагирует на ваши запросы.

Свитчи Mellanox работают на Switchdev, что превращает их порты в простые интерфейсы внутри Linux. Будучи частью основного ядра Linux, Switchdev предоставляет удобный способ управления устройством с помощью понятных и привычных интерфейсов, под одним API, к которому абсолютно привычен любой современный программист, разработчик и сетевой инженер. Любая программа, использующая стандартный сетевой API Linux, может быть запущена на свитче. Весь мониторинг сетевой активности и управление им, созданное для серверов на Linux, включая возможные собственные решения, легко доступны. Для иллюстрации изменений, произошедших с активным развитием Switchdev отметим, что модификация таблиц маршрутизации стала в разы быстрее и удобнее со Switchdev. До самого уровня сетевого чипа весь код виден и прозрачен, что позволяет учиться и делать вносить модификации до того момента, когда вам потребуется знать, как именно построен сам чип или, как минимум, внешний интерфейс к нему.

Устройство Mellanox под управлением Switchdev оказалось долгожданной комбинацией, которой мы так долго ждали, но что еще лучше — компания-производитель оправдала все ожидания и требования, не только в вопросе полной поддержки свободной операционной системы из коробки.

Тестируя оборудование перед запуском в эксплуатацию, мы выяснили что часть перенаправленного трафика теряется. Наше расследование показало, что это было вызвано тем, что трафик на один из интерфейсов направлялся с помощью контрольного процессора, который не мог справится с высоким его объемом. Не будучи в состоянии определить точную причину такого поведения, мы, однако, предположили что это связано с обработкой ICMP-редиректов. Mellanox подтвердил источник проблемы, а потому мы попросили что-то сделать с таким поведением устройства, на что компания отреагировала мгновенно, предоставив рабочее решение за короткий срок.

Отличная работа, Mellanox!

Протоколы и опенсорс

DNS-over-HTTPS представляет собой более комплексную технологию, нежели DNS-over-TLS. Мы наблюдаем, как первый процветает, в то время как о втором медленно забывают. Данный пример хорош тем, что в этом конкретном случае «сложность» означает «эффективность», так как трафик DoH неразличим от любого другого HTTPS. Мы уже видели то же самое с интеграцией данных RPKI, изначально позиционировавшемся как решение для анти-перехвата и, в итоге, с ним не случилось ничего хорошего. Спустя некоторое время RPKI вновь появился на сцене, как мощный инструмент против таких аномалий, как утечка маршрутов и некорректные настройки маршрутизации. И вот шум трансформировался в сигнал, а RPKI начал поддерживаться на крупнейших точках обмена трафиком, что является отличной новостью.

Прибыл и TLS 1.3. Qrator Labs, как и вся индустрия информационных технологий, пристально следила за процессом разработки нового стандарта шифрования на каждом этапе, от первоначального черновика в IETF до понятного и управляемого протокола, который мы готовы поддерживать начиная с 2019 года. Рынок отреагировал аналогично, обещая скорейшее внедрение заслужившего доверие протокола безопасности. Возможно, что не все производители решений по нейтрализации DDoS смогут одинаково быстро адаптироваться к изменившейся реальности, ведь из-за технической сложности поддержки протокола в железе могут возникнуть объяснимые задержки.

Мы также следим за продолжающимся развитием HTTP/2. На текущий момент, мы не поддерживаем новую версию протокола HTTP, в первую очередь из-за несовершенства актуальной кодовой базы. Баги и уязвимости все еще слишком часто обнаруживаются в новом коде; как поставщик решения безопасности, мы еще не готовы поддерживать данный протокол под SLA, с которым согласились наши потребители.

В 2018 году мы часто задавали себе вопрос: «Почему люди так сильно хотят HTTP/2?», что являлось причиной многочисленных ожесточенных дебатов. Люди все еще склонны думать о вещах с приставкой «2», как о «более лучших» версиях чего угодно, что особенно верно конкретно в случае некоторых аспектов реализации данного протокола. Тем не менее, DoH рекомендует использование именно HTTP/2 и, вполне возможно, из этой синергии родится высокая степень принятия рынком обоих протоколов.

Одним из переживаний при рассмотрении разработки протоколов следующего поколения и их планируемых возможностей является тот факт, что очень часто разработки не выходят за чисто академический уровень, не говоря о рассмотрении таких крайних по-мнению создателей протоколов случаев, как нейтрализация DDoS-атак. Возможно, это является причиной, по которой и занимающиеся кибер и инфобезопасностью компании прикладывают мало усилий в разработке таких стандартов. Секция 4.4 черновика IETF под названием «QUIC manageability», являющегося частью будущего пакета протокола QUIC, является просто идеальным примером такого подхода: в ней утверждается, что «текущие практики в детектировании и нейтрализации [DDoS-атак] в большинстве своем задействуют пассивное измерение с использованием данных сетевого уровня». Последнее крайне редко используется на деле, за исключением разве что сетей интернет-провайдеров и вряд ли является «общим случаем» на практике. Однако в академической исследовательской бумаге «общие случаи» формируются именно так, в результате чего финальные стандарты протоколов оказываются просто-напросто неприменимы в продакшене, после совершения таких простых манипуляций перед вводом в эксплуатацию, как тестирование под нагрузкой и имитация атак прикладного уровня на приложение, их использующее. Принимая во внимание продолжающийся процесс внедрения TLS в глобальную инфраструктуру интернета, утверждение о каком либо пассивном мониторинге вообще подвергается серьезному сомнению. Выстраивание корректных академических исследований — еще одно испытание для поставщиков решений безопасности в 2019 году.

В то же время, Switchdev полностью оправдал ожидания, которые были заложены в него год назад. Мы надеемся, что непрестанная работа над Switchdev приведет сообщество и общий плод труда к отличным результатам уже в ближайшем будущем.

Дальнейшее развитие и внедрение Linux XDP поможет индустрии добиться высоких значений эффективности обработки сетевых пакетов. Отгрузка некоторых паттернов фильтрации нелегитимного трафика с центрального процессора на сетевой процессор, а в некоторых случаях даже на свитч, уже выглядит многообещающе и наша компания продолжает собственные исследования и разработку в данной области.

Глубокое погружение с ботами

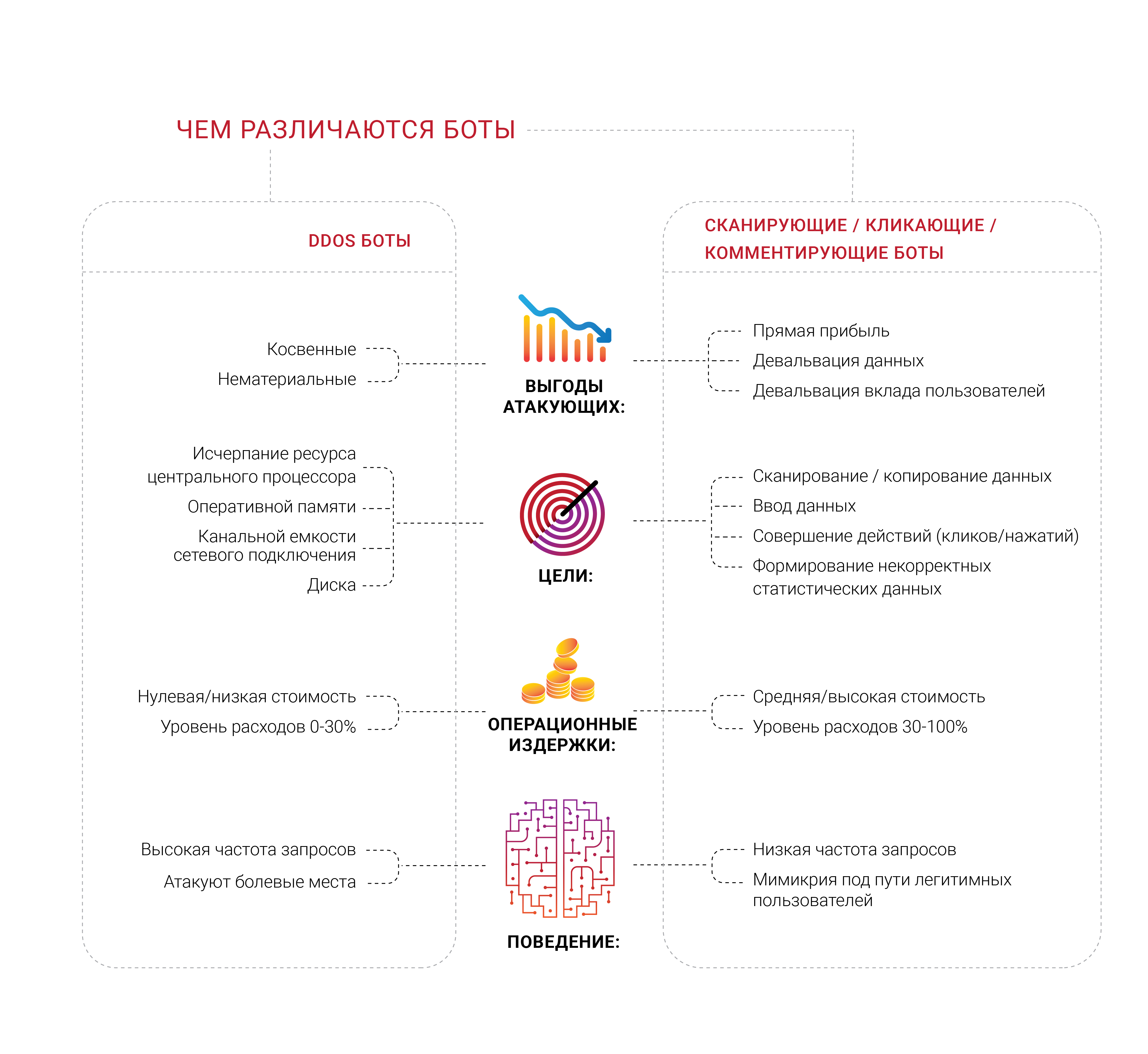

Многие компании стремятся получить защиту от ботов и, что неудивительно, мы увидели большое количество разнообразных групп профессионалов работающих над различными областями данной проблематики в 2018 году. Что нам кажется отдельно интересным, так это то, что большая часть компаний, формирующих подобный спрос, никогда не испытывала целенаправленной DDoS-атаки, по-меньшей мере типичной, направленной на исчерпание конечных ресурсов, таких как память, процессор или канал сетевого подключения. Они боятся ботов, но не могут отличить их от легитимных пользователей или определить, что же именно они делают. Большинство источников таких обращений хотят избавиться от ощущения, что к ним на страницы приходят не живые люди.

Проблематика ботов-сканеров и многих других подвидов заключается в очень важной экономической компоненте. Если 30% трафика нелегитимны и происходят от нежелательных источников, то 30% затрат на поддержку такого трафика оказываются выброшены в мусор, по логике расходов. Сегодня можно рассматривать подобное как неизбежный «налог интернета» на бизнес. Это число практически невозможности свести к нулю, но владельцы бизнеса по возможности хотят видеть данный процент как можно меньшим.

Идентификация становится крайне серьезной проблемой и задачей в современном интернете, так как самые продвинутые боты даже не пытаются изображать человека — они им управляют и находятся в одном с ним пространстве, похожим на паразитов образом. Мы повторяли в течение уже длительного времени что любая информация, доступная публично, без аутентификации и авторизации есть и, в конечном итоге, закончит свое существование в виде общественного достояния — никто не может предотвратить это.

Рассматривая данную проблематику, мы сконцентрировались на вопросах идентификации и управления ботами. Однако, на наш взгляд широкий спектр работы куда более интересен — мы живем в эпоху, когда уже невозможно узнать, почему тот или иной клиент запрашивает что-то у сервера. Вы все верно прочитали — в конечном итоге любой бизнес хочет знать, что потребитель пришел за покупкой, ведь это цель его, бизнеса, существования. Поэтому некоторые компании хотят взглянуть вглубь того, кто и что запрашивает у их серверов — есть ли за запросом реальный человек.

Неудивительно, в итоге, что часто владельцы бизнеса узнают о том, что значительная доля трафика их веб сайта сгенерирована роботами, а никакими не покупателями.

Автоматизированные человеческий особи, которых мы уже упоминали в ином контексте, могут быть нацелены на куда более специфические сетевые ресурсы пользуясь вещами почти незаметными, такими как расширения для браузера. Мы уже знаем, что очень многие расширения, которые пока сложно назвать «вредоносными» существуют исключительно с целью сбора и анализа поведения реального пользователя. А ведь есть и совсем другие вещи — там, где автоматика не может пройти выставленное перед ней заграждение, появляются люди с модификациями браузеров и совершают все те же простые действия, возможно, лишь чуть дороже для организаторов. К тому же ряд задач, таких как манипуляции рекламой и кликфрод гораздо эффективнее выполняются с реальным человеком перед экраном. Только представьте, что может произойти, если кто-то найдет хороший способ усилить все еще и машинным обучением, в нужном участке данной цепи.

Парсеры и сканеры, являющиеся частью широкой проблематики ботов, вышли на наш горизонт только в 2018 году и, в первую очередь, благодаря нашим потребителям, сообщившим нам о собственном опыте и предоставивших возможность глубже изучить и проанализировать то, что происходило на их сетевых ресурсах. Такие боты могут быть даже не видны на уровне стандартных метрик, таких как средняя используемая сетевая полоса или загрузка центрального процессора сервера. В настоящий момент Qrator Labs тестирует разнообразные подходы, но очевидно одно — наши потребители хотят, чтобы вредоносные по их мнению боты были заблокированы на первом же запросе к серверу.

Во время эпидемии парсинга, которую мы наблюдали в России и СНГ всю вторую половину 2018 года, стало очевидно, что боты далеко продвинулись в вопросах шифрования. Один запрос в минуту — это вполне нормальная интенсивность для бота, которую очень сложно заметить без анализа запросов и исходящего трафика ответов. По нашему скромному мнению, только потребитель вправе решать, что делать с любым нежелательным источником запросов после анализа и маркировки трафика. Блокировать, пропустить или обмануть — решать не нам.

Тем не менее, у чисто автоматических решений, или как мы их привыкли называть — «ботов», существуют определенные трудности во взаимодействии. Если вы уверены, что именно бот сгенерировал нежелательный и вполне специфический запрос, первая вещь, которую захочет сделать большинство — заблокировать его, не отвечая от сервера. Тем не менее, мы пришли к выводу, что подобный подход бессмысленен, ибо дает слишком много обратной связи как самому боту, так и его создателю и стимулирует искать обходной путь. Если боты не пытаются вывести сервис из рабочего состояния, в общем и целом мы советуем не проповедовать такой подход — в результате игры в кошки-мышки достаточно целеустремленный злоумышленник почти всегда обойдет вас в погоне за целью, какой бы она ни была.

Это же является причиной, по которой Qrator Labs приняла подход маркировки вредоносного, равно как и всего трафика в общем, для того чтобы предоставить владельцу приложения максимум данных и возможностей для принятия взвешенного решения, рассмотрев возможные последствия для пользователей и бизнес-целей. Одним из хороших примеров, иллюстрирующих возможные последствия, являются блокировщики рекламы. Большая часть современной рекламы в интернете представлена именно в форме скриптов, блокируя которые вы совершенно не обязательно заблокируете именно рекламу, а не, допустим, javascript-проверку сервиса защиты от DDoS. Легко представить, куда может завести эта тропа, в конечном итоге выливаясь в снижение прибыли интернет-бизнеса.

Когда атакующие блокируются и получаются необходимую им обратную связь, ничто не мешает им адаптироваться, учиться и атаковать снова. Наши технологии построены вокруг простой философии того, что предоставлять роботам обратную связь не обязательно — нужно ни блокировать, ни пропускать их, но просто детектировать и маркировать. После того, как подобная маркировка сделана и мы уверены в ее точности, правильно задать следующий вопрос: «Что им нужно?» и «Почему они заинтересованы именно в этом?» Возможно, достаточно лишь слегка изменить контент веб-страницы так, что ни один живой человек не почувствует разницы, но реальность бота перевернется с ног на голову? Если это парсеры — то возможно, что определенный процент данных окажется некорректным и фальшивым, но это в любом случае выведет защиту из поиска бинарных нуля или единицы и даст то, что действительно необходимо — время.

Обсуждая данную проблематику на протяжении всего 2018 года мы назвали атаки, подобные описанным, атаками на бизнес-метрики. Веб сайт, приложение и сервер могут работать просто замечательно, а ни один пользователь не будет жаловаться, но вы все равно что-то чувствуете… вроде падения CPA от рекламы, которую вы берете для размещения на программатик-платформе, толкая рекламодателей в сторону ее, даже не ваших, конкурентов.

Снижение поощрения атакующего — единственный способ противодействия. Попытка остановить ботов не принесет ничего, кроме потраченных времени и средств. Если что угодно кликает на то, что дает вам прибыль — отмените эти клики; если вас парсят, вы можете включить слой «фальшивой» информации, через которую с легкостью пройдет обычный, любопытный, пользователь в поисках корректной и достоверной информации.

Clickhouse

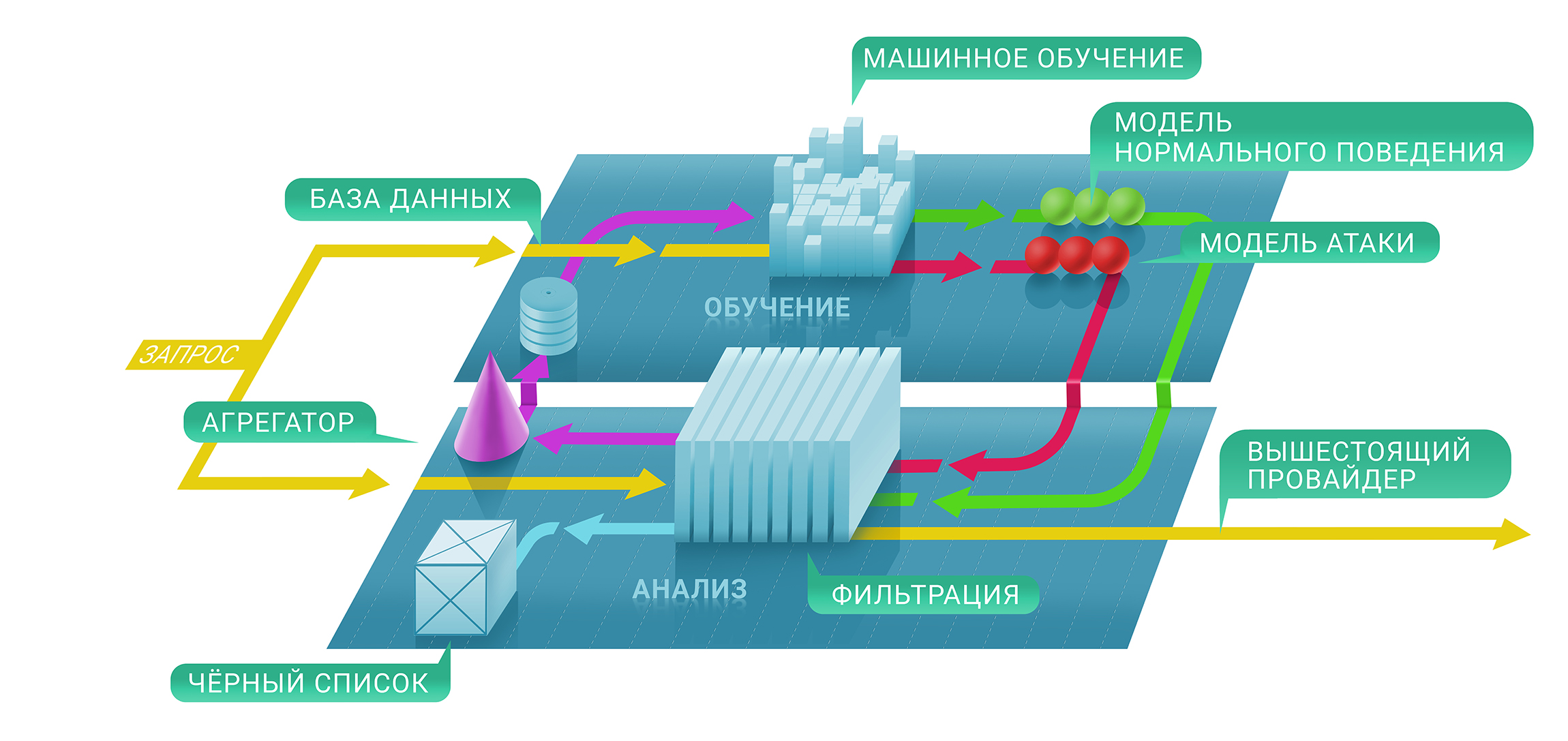

На высоком уровне сервис фильтрации Qrator состоит из двух уровней: на первом мы незамедлительно оцениваем, если определенный запрос является злонамеренным с помощью проверок с сохранением состояния и без и, на втором, принимаем решение о том, задержать ли источник в черном списке и на какой срок. Получающийся в итоге черный список может быть представлен в виде уникальной таблицы IP-адресов.

На первом этапе данного процесса мы задействуем техники машинного обучения для того, чтобы лучше понимать естественные уровни и характеристики трафика для каждого ресурса в отдельности, так как каждый параметры защиты каждого отдельного сервиса настраиваются индивидуально на базе собираемых нами метрик.

Здесь в дело вступает Clickhouse. Для того чтобы лучше понять, почему определенный IP-адрес был заблокирован от общения с ресурсом, нам нужно проследить весь путь машинного обучения вплоть до базы данных Clickhouse. Она работает очень быстро с большими кусками данных (представьте себе DDoS-атаку интенсивностью 500 Гбит/сек и продолжающуюся несколько часов чистого времени вне пауз) и хранит их в удобном виде для фреймворка машинного обучения, используемого в Qrator Labs. Больше логов и больше сохраненного трафика DDoS-атак ведут к точным результатам от наших моделей, помогающих осуществлять тонкую настройку сервиса фильтрации в реальном времени, под наиболее серьезными атаками.

Мы используем Clickhouse DB для хранения всех логов нелегитимного трафика атак и паттернов поведения ботов. Данное, специализированное, решение было выбрано нами из-за высокого потенциала хранения массивных датасетов в стиле классической базы данных с целью последующей обработки. Анализ этих данных используется в том числе для построения паттернов DDoS-атак, помогая машинному обучению постоянно улучшать наши алгоритмы фильтрации трафика.

Значительным преимуществом Clickhouse, в сравнении с другими базами данных, является то, что ей не нужно считывать целую строковую переменную данных — она может взять гораздо меньший, строго необходимый, сегмент, если вы храните все по рекомендациям. И это работает, быстро!

Заключение

На протяжении уже длительного времени мы живем в мире мультифакторных атак, эксплуатирующих атакующие возможности сразу нескольких протоколов для выведения цели из работоспособного состояния.

Цифровая гигиена и актуальные меры безопасности должны и, на самом деле, покрывают порядка 99% существующих рисков, которые может встретить обыкновенный пользователь, за исключением лишь, пожалуй, узкоспециализированных атак на конкретные цели.

С другой стороны, в современном интернете существуют акулы, способные перекусить доступность целых государств. Это не касается BGP, где возможно погасить лишь некоторые точки на любой карте, которую злоумышленник захочет нарисовать.

Уровень знаний, касаемый сетевой безопасности продолжает расти. Тем не менее, если вы взглянете на цифры связанные с количеством амплификаторов в сетях или поищите возможности подделки запросов — количество уязвимых сервисов и серверов не падает. Ежедневный темп приобретения молодыми людьми знаний, касаемых навыков программирования и управления компьютерными сетями не соответствует времени, необходимому для получения соответствующего опыта в реальной жизни. Уверенность в том, что с новыми продуктами не выходят новые уязвимости приобретается долго, а главное — больно.

Одним из наиболее удивительных открытий прошедшего года было то, что большинство людей ожидает от новых технологий существенно больше, чем те способны предоставить. Так было не всегда, однако прямо сейчас мы наблюдаем растущую тенденцию людей «требовать большего» вне зависимости от возможностей софта и тем более, железа. Это ведет нас в мир достаточно извращенных маркетинговых кампаний. Но люди, тем не менее, продолжают «покупать обещания» а компании, в свою очередь, чувствуют себя обязанными их исполнить.

Возможно это и есть суть прогресса и эволюции. Сейчас многие расстраиваются из-за факта не получения «гарантированного» и того, за что были уплачены средства. Из невозможности «полностью» купить устройство у производителя и растут многие из современных проблем, в обратную же сторону стоимость «бесплатных» сервисов может получаться просто баснословной, если рассмотреть кумулятивную стоимость данных, которые получает от пользователя крупная социальная сеть, не требующая оплаты.

Консьюмеризм говорит нам, что если мы очень сильно чего то хотим, то, в конечном счете, заплатим собственными жизнями. Действительно ли нам нужны подобные продукты и сервисы, улучшающие себя только для того, чтобы предлагать нам «улучшенные предложения» на основе тех данных, что собрали о нас, нравится нам это или нет? Тем не менее, это судя по всему и есть ближайшее будущее, как нам показали случаи с Equifax и Cambridge Analytica совсем недавно. Неудивительно, если впереди нас ждет «большой взрыв» использования персональных и прочих, касающихся индивидуальной жизни каждого, данных.

Спустя десять лет работы мы не поменяли ключевые устои об архитектуре интернета. Это причина, по которой мы продолжаем развивать BGP anycast сеть фильтрации с возможностью обработки зашифрованного трафика именно в таком виде, избегая капчи и других неожиданных для легитимного пользователя препятствий.

Наблюдая за тем, что продолжает происходить с экспертами в области кибербезопасности, равно как и компаниями в данном поле, мы еще раз хотим повторить очевидное: наивный, простой и быстрый подход неприменим.

Поэтому у Qrator Labs нет сотен или даже десятков точек присутствия, сравнимых с CDN. Управляя меньшим количеством центров фильтрации, каждый из которых подключен к интернет-провайдерам классом не ниже Tier-1, мы добиваемся настоящей децентрализации. По этой же причине мы не пытаемся строить свой собственный файрвол, представляющий собой задачу совершенно иного уровня, нежели та, над которой мы работаем — связностью.

На протяжении многих лет мы говорили, что в конечном итоге не сработает ни капча, ни javascript-проверка и вот мы находимся в 2019 году, когда нейросети стали высокоэффективны в решении первых, а вторые вообще никогда не представляли собой проблему для атакующего с мозгом.

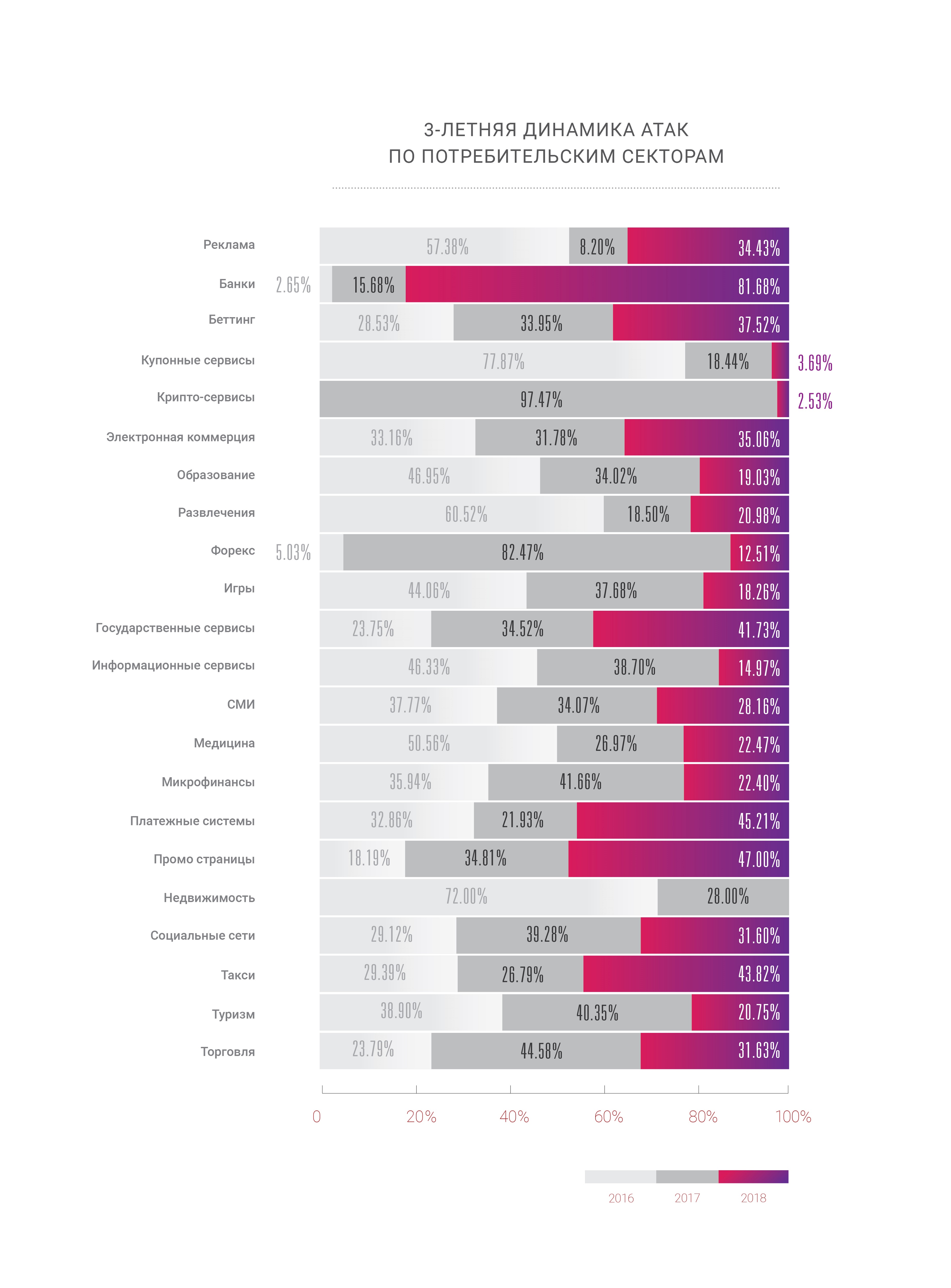

Хотелось бы отметить еще одно интересное изменение на границе времени: DDoS-атаки долгое время были серьезной проблемой лишь для ограниченного числа бизнес отраслей, как правило тех, где деньги покачиваются на поверхности: электронная коммерция, торговля и биржа, банкинг и платежные системы. Но с продолжающимся развитием интернета, мы наблюдаем DDoS-атаки увеличенной интенсивности и частоты в абсолютно всех частях интернета. Эпоха DDoS началась с определенного порога пропускной способности домашних роутеров и, неудивительно, что с появлением микрочипа в каждой физической вещи вокруг ландшафт атак начал стремительно меняться.

Тот, кто либо ожидает окончания развития данной тенденции, скорее всего неправ. Также, как неправы и мы, написав так много предсказаний. Никто не может утверждать наверняка, как именно интернет будет развиваться и распространять собственное влияние в ближайшие годы, но оглядываясь на то, что мы видели, понятно одно — все умножится. В 2020 году количество подключенных к сети устройств должно превысить 30 миллиардов, не говоря о том простом факте, что роботы уже давно генерируют гораздо больше трафика, чем люди. Совсем скоро нам придется решать, что делать со всем этим «интеллектом», искусственным или нет, так как мы до сих пор существуем в мире где человеческая особь ответственна за свои поступки, правильные или нет.

2018 год был годом возможностей для темной стороны. Мы увидели и рост атак, с одновременным их усложнением и увеличением как объема в сетевых терминах, так и частоты. Злодеи получили мощные инструменты и потратили немало времени на их изучение, в то время, как хорошие парни не делали ничего более, нежели наблюдали за их прогрессом. Мы искренне надеемся, что в текущем году изменится хоть что то, по меньшей мере в наиболее болезненных местах.

→ Ссылка на полную версию отчета на русском языке